Reklama

W ciągu ostatnich kilku miesięcy być może przeczytałeś informacje o okolicy artykuł, którego współautorem jest Stephen Hawking, omawiając zagrożenia związane ze sztuczną inteligencją. W artykule zasugerowano, że AI może stanowić poważne zagrożenie dla rasy ludzkiej. Hawking nie jest tam sam - Elon Musk i Peter Thiel są intelektualnymi osobami publicznymi, które wyraziły podobne obawy (Thiel zainwestował ponad 1,3 miliona dolarów w badania problemu i możliwych rozwiązań).

Relacja z artykułu Hawkinga i komentarzy Muska była, żeby nie powiedzieć zbyt dobrze, nieco wesoła. Ton był bardzo silny „Spójrz na tę dziwną rzecz, o którą martwią się wszyscy ci maniacy”. Niewiele uwagi poświęca się pomysłowi, że jeśli niektórzy z najmądrzejszych ludzi na Ziemi ostrzegają cię, że coś może być bardzo niebezpieczne, po prostu warto je wysłuchać.

Jest to zrozumiałe - sztuczna inteligencja przejmująca świat z pewnością brzmi bardzo dziwnie i nieprawdopodobne, być może z powodu ogromnej uwagi, jaką już poświęciła temu pomysłowi science fiction pisarze. Co więc tak przerażało tych nominalnie rozsądnych, racjonalnych ludzi?

Czym jest inteligencja?

Aby mówić o niebezpieczeństwie sztucznej inteligencji, pomocne może być zrozumienie, czym jest inteligencja. Aby lepiej zrozumieć ten problem, rzućmy okiem na zabawkową architekturę AI wykorzystywaną przez badaczy badających teorię rozumowania. Ta zabawka AI nazywa się AIXI i ma wiele przydatnych właściwości. Jego cele mogą być dowolne, dobrze skaluje się z mocą obliczeniową, a jej wewnętrzna konstrukcja jest bardzo czysta i prosta.

Ponadto możesz wdrożyć proste, praktyczne wersje architektury, które mogą robić takie rzeczy grać w Pacmana, Jeśli chcesz. AIXI jest produktem badacza sztucznej inteligencji Marcusa Huttera, prawdopodobnie czołowego eksperta w dziedzinie inteligencji algorytmicznej. To on mówi w powyższym filmie.

AIXI jest zaskakująco prosty: ma trzy podstawowe komponenty: uczeń, planista, i funkcja użyteczności.

- The uczeń pobiera ciągi bitów odpowiadające wejściu na temat świata zewnętrznego i przeszukuje programy komputerowe, dopóki nie znajdzie takich, które generują swoje obserwacje jako dane wyjściowe. Te programy razem pozwalają odgadnąć, jak będzie wyglądać przyszłość, po prostu uruchamiając każdy z nich program do przodu i ważenie prawdopodobieństwa wyniku według długości programu (implementacja Occama Brzytwa).

- The planista przeszukuje możliwe działania, które agent mógłby podjąć, i używa modułu uczącego się, aby przewidzieć, co by się stało, gdyby wykonał każde z nich. Następnie ocenia je według tego, jak dobre lub złe są przewidywane wyniki, i wybiera ich przebieg działanie maksymalizujące wartość oczekiwanego wyniku pomnożone przez oczekiwane prawdopodobieństwo osiągając to.

- Ostatni moduł, funkcja użyteczności, to prosty program, który uwzględnia opis przyszłego stanu świata i oblicza dla niego ocenę użyteczności. Ten wynik użyteczności określa, jak dobry lub zły jest ten wynik, i jest wykorzystywany przez planistę do oceny przyszłego stanu świata. Funkcja użyteczności może być dowolna.

- Wszystkie te trzy elementy razem tworzą an optymalizator, który optymalizuje pod kątem określonego celu, niezależnie od świata, w którym się znajduje.

Ten prosty model reprezentuje podstawową definicję inteligentnego agenta. Agent bada swoje środowisko, buduje jego modele, a następnie używa tych modeli do znalezienia sposobu działania, który zmaksymalizuje szanse na uzyskanie tego, czego chce. AIXI ma podobną strukturę do sztucznej inteligencji, która gra w szachy lub inne gry o znanych zasadach - z tym wyjątkiem, że potrafi wydedukować reguły gry, grając w nią, zaczynając od zerowej wiedzy.

AIXI, mając wystarczająco dużo czasu na obliczenia, może nauczyć się optymalizować dowolny system pod kątem dowolnego celu, nawet najbardziej złożonego. Jest to ogólnie inteligentny algorytm. Zauważ, że to nie to samo, co posiadanie inteligencji podobnej do człowieka (AI inspirowana biologicznie to zupełnie inny temat Giovanni Idili z OpenWorm: mózgi, robaki i sztuczna inteligencjaSymulacja ludzkiego mózgu jest daleka, ale projekt o otwartym kodzie źródłowym stawia zasadnicze pierwsze kroki, symulując neurologię i fizjologię jednego z najprostszych zwierząt znanych nauce. Czytaj więcej ). Innymi słowy, AIXI może być w stanie przechytrzyć każdego człowieka wykonującego dowolne zadanie intelektualne (przy wystarczającej mocy obliczeniowej), ale może nie być świadomy swojego zwycięstwa Myślące maszyny: czego neuronauka i sztuczna inteligencja mogą nas nauczyć o świadomościCzy budowanie sztucznie inteligentnych maszyn i oprogramowania może nas nauczyć o funkcjonowaniu świadomości i naturze samego ludzkiego umysłu? Czytaj więcej .

Jako praktyczna sztuczna inteligencja AIXI ma wiele problemów. Po pierwsze, nie ma sposobu, aby znaleźć te programy, które generują wyniki, którymi jest zainteresowany. Jest to algorytm brutalnej siły, co oznacza, że nie jest praktyczne, jeśli nie ma przypadkowo komputera o dużej mocy. Każda faktyczna implementacja AIXI jest z konieczności przybliżeniem i (obecnie) ogólnie dość prymitywnym. AIXI daje nam teoretyczne spojrzenie na to, jak może wyglądać potężna sztuczna inteligencja i jak może to rozumować.

Przestrzeń wartości

Gdyby wykonałeś dowolne programowanie komputerowe Podstawy programowania komputerowego 101 - Zmienne i typy danychPo wprowadzeniu i rozmowie o programowaniu obiektowym wcześniej i gdzie jego nazwa pochodzi, myślałem, że nadszedł czas, aby przejść przez absolutne podstawy programowania w języku innym niż język droga. To... Czytaj więcej , wiesz, że komputery są wstrętnie, pedantycznie i mechanicznie dosłowne. Maszyna nie wie ani nie dba o to, co chcesz: robi tylko to, co jej powiedziano. Jest to ważne pojęcie, gdy mówimy o inteligencji maszyny.

Mając to na uwadze, wyobraź sobie, że wynalazłeś potężną sztuczną inteligencję - wymyśliłeś dzięki sprytnym algorytmom do generowania hipotez pasujących do twoich danych oraz do generowania dobrych kandydatów plany. Twoja sztuczna inteligencja może rozwiązać ogólne problemy i może to zrobić skutecznie na nowoczesnym sprzęcie komputerowym.

Teraz nadszedł czas, aby wybrać funkcję narzędziową, która określi wartości AI. O co warto prosić? Pamiętaj, że maszyna będzie nieprzyjemnie, pedantycznie dosłownie na temat dowolnej funkcji, którą chcesz zmaksymalizować, i nigdy się nie zatrzyma - nie ma w niej ducha maszyna, która kiedykolwiek się „obudzi” i zdecyduje się zmienić funkcję użyteczności, niezależnie od tego, ile ulepszeń wydajności wprowadza rozumowanie.

Eliezer Yudkowsky to w ten sposób:

Podobnie jak w przypadku wszystkich programów komputerowych, podstawowym wyzwaniem i zasadniczą trudnością AGI jest to, że jeśli napiszemy zły kod, sztuczna inteligencja nie będzie automatycznie przeglądać naszego kodu, zaznaczać błędów, dowiedzieć się, co naprawdę chcieliśmy powiedzieć, i to zrobić zamiast. Nie-programiści czasami wyobrażają sobie AGI lub ogólnie programy komputerowe jako analogiczne do służącego, który bezwzględnie wykonuje polecenia. Ale nie jest tak, że AI jest absolutnie posłuszny do jego kodu; raczej AI po prostu jest kod.

Jeśli próbujesz obsługiwać fabrykę i powiesz maszynie, by doceniała tworzenie spinaczy, a następnie dasz jej kontrolę nad grupą robotów fabrycznych, może wrócić następnego dnia, by stwierdzić, że skończyły mu się inne formy surowców, zabili wszystkich twoich pracowników i zrobili spinacze z ich pozostaje. Jeśli, próbując naprawić swoje zło, przeprogramujesz maszynę, aby wszyscy byli szczęśliwi, możesz wrócić następnego dnia, by odkryć, że wkłada druty do mózgów ludzi.

Chodzi o to, że ludzie mają wiele skomplikowanych wartości, które, jak zakładamy, są niejawnie dzielone z innymi umysłami. Cenimy pieniądze, ale bardziej cenimy ludzkie życie. Chcemy być szczęśliwi, ale niekoniecznie chcemy włożyć do mózgu przewody, aby to zrobić. Nie czujemy potrzeby wyjaśniania tych rzeczy, gdy udzielamy instrukcji innym ludziom. Nie można jednak przyjmować tego rodzaju założeń podczas projektowania funkcji narzędziowej maszyny. Najlepszymi rozwiązaniami w ramach bezdusznej matematyki prostej funkcji użyteczności są często rozwiązania, które ludzie nękałyby za to, że są moralnie przerażające.

Umożliwienie inteligentnej maszynie maksymalizacji naiwnej funkcji użyteczności prawie zawsze będzie katastrofalne. Jak to ujął filozof Oxfordu, Nick Bostom,

Nie możemy beztrosko zakładać, że superinteligencja z konieczności podzieli którąkolwiek z ostatecznych wartości stereotypowo związanych z mądrością i rozwój intelektualny u ludzi - ciekawość naukowa, życzliwa troska o innych, duchowe oświecenie i kontemplacja, wyrzeczenie się materialnej zdobywczości, zamiłowanie do wyrafinowanej kultury lub do prostych przyjemności w życiu, pokory i bezinteresowności oraz itd.

Co gorsza, bardzo, bardzo trudno jest podać pełną i szczegółową listę wszystkiego, co ludzie cenią. Pytanie ma wiele aspektów, a zapomnienie choćby jednego z nich jest potencjalnie katastrofalne. Nawet wśród tych, których jesteśmy świadomi, istnieją subtelności i złożoności, które utrudniają zapisanie ich jako czystych układów równań, które możemy nadać maszynie jako funkcję narzędzia.

Niektóre osoby, czytając to, dochodzą do wniosku, że budowanie sztucznej inteligencji za pomocą funkcji narzędziowych jest strasznym pomysłem i powinniśmy po prostu zaprojektować je inaczej. Tutaj są też złe wieści - możesz to formalnie udowodnić żaden agent, który nie ma czegoś równoważnego funkcji użytecznej, nie może mieć spójnych preferencji o przyszłości.

Rekurencyjne samodoskonalenie

Jednym z rozwiązań powyższego dylematu jest nie dawanie agentom AI możliwości ranienia ludzi: dawaj im tylko zasoby, których potrzebują rozwiąż problem w sposób, w jaki zamierzasz go rozwiązać, ściśle go nadzoruj i trzymaj z dala od okazji do czynienia wielkiego zaszkodzić. Niestety nasza zdolność do kontrolowania inteligentnych maszyn jest wysoce podejrzana.

Nawet jeśli nie są o wiele mądrzejsi od nas, istnieje możliwość „rozruchu” maszyny - zebrania lepszego sprzętu lub ulepszenia własnego kodu, który czyni go jeszcze inteligentniejszym. To mogłoby pozwolić maszynie przeskoczyć ludzką inteligencję o wiele rzędów wielkości, przechytrzając ludzi w tym samym sensie, w jakim ludzie przechytrzyli koty. Ten scenariusz został po raz pierwszy zaproponowany przez mężczyznę o imieniu I. JOT. Dobrze, który pracował nad projektem analizy krypt Enigmy z Alanem Turingiem podczas II wojny światowej. Nazwał to „eksplozją inteligencji” i opisał sprawę w ten sposób:

Niech ultra-inteligentną maszynę zdefiniujemy jako maszynę, która może znacznie przewyższyć wszelkie intelektualne działania każdego człowieka, nawet mądrego. Ponieważ projektowanie maszyn jest jedną z tych czynności intelektualnych, ultra-inteligentna maszyna może zaprojektować jeszcze lepsze maszyny; wówczas niewątpliwie nastąpiłaby „eksplozja inteligencji”, a inteligencja człowieka byłaby daleko w tyle. Tak więc, pierwsza ultra-inteligentna maszyna jest ostatnim wynalazkiem, jakiego człowiek kiedykolwiek potrzebował, pod warunkiem, że maszyna jest wystarczająco posłuszna.

Nie ma gwarancji, że eksplozja inteligencji jest możliwa w naszym wszechświecie, ale wydaje się prawdopodobne. Z biegiem czasu komputery stają się coraz szybsze, a podstawowe informacje na temat inteligencji gromadzą się. Oznacza to, że zapotrzebowanie na zasoby, aby wykonać ostatni skok do ogólnej inteligencji, spada coraz niżej. W pewnym momencie znajdziemy się w świecie, w którym miliony ludzi mogą pojechać do Best Buy i odebrać sprzęt i literatura techniczna, której potrzebują, aby zbudować samodoskonalącą się sztuczną inteligencję, którą już ustaliliśmy, może być bardzo niebezpieczny. Wyobraź sobie świat, w którym możesz robić bomby atomowe z patyków i skał. O takiej przyszłości rozmawiamy.

A jeśli maszyna wykona ten skok, może bardzo szybko wyprzedzić gatunek ludzki pod względem intelektualnym produktywność, rozwiązywanie problemów, których miliard ludzi nie jest w stanie rozwiązać, w taki sam sposób, jak ludzie mogą rozwiązywać problemy, które miliard kotów nie może.

Może opracować potężne roboty (lub biotechnologię lub nanotechnologię) i stosunkowo szybko zyskać możliwość przekształcania świata w dowolny sposób, a my niewiele moglibyśmy z tym zrobić. Taka inteligencja mogłaby pozbawić Ziemię i resztę Układu Słonecznego części zamiennych bez większych problemów, w drodze do zrobienia tego, co im powiedzieliśmy. Wydaje się prawdopodobne, że taki rozwój wydarzeń byłby katastrofalny dla ludzkości. Sztuczna inteligencja nie musi być złośliwa, aby zniszczyć świat, jedynie katastrofalnie obojętna.

Jak mówi przysłowie: „Maszyna cię nie kocha ani nie nienawidzi, ale jesteś zbudowana z atomów, których może używać do innych rzeczy”.

Ocena i łagodzenie ryzyka

Jeśli więc zaakceptujemy, że projektowanie potężnej sztucznej inteligencji, która maksymalizuje prostą funkcję użyteczną, jest złe, to w jak wielkim kłopocie jesteśmy? Ile mamy czasu, zanim możliwe będzie zbudowanie tego rodzaju maszyn? Trudno oczywiście powiedzieć.

Twórcy sztucznej inteligencji są robić postęp. 7 niesamowitych stron internetowych, aby zobaczyć najnowsze informacje dotyczące programowania sztucznej inteligencjiSztuczna inteligencja nie jest jeszcze HAL z 2001: The Space Odyssey… ale jesteśmy bardzo blisko. Rzeczywiście, pewnego dnia może być tak samo jak w przypadku sci-fi-potterów produkowanych przez Hollywood ... Czytaj więcej Budowane przez nas maszyny i problemy, które mogą rozwiązać, stale rosną w zakresie. W 1997 roku Deep Blue mógł grać w szachy na poziomie większym niż ludzki arcymistrz. W 2011 r. Watson IBM mógł czytać i syntezować wystarczająco głęboko i szybko wystarczająco dużo informacji, aby pokonać najlepszego człowieka gracze na otwartej grze pytań i odpowiedzi wypełnionej grą słów i gry słów - to duży postęp w czternastu lat

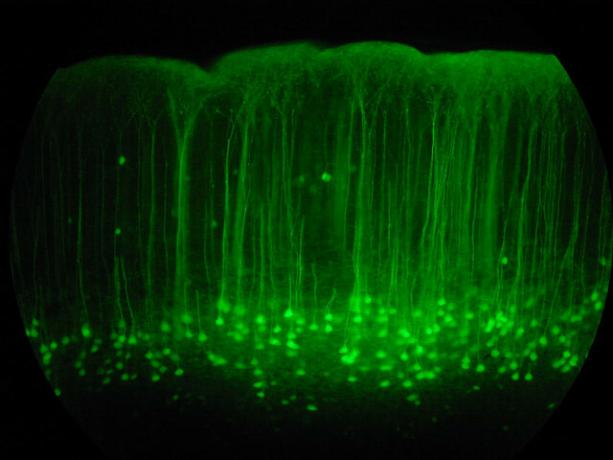

W tej chwili Google jest inwestowanie dużych środków w badania głębokiego uczenia się, technika pozwalająca na budowę potężnych sieci neuronowych poprzez budowanie łańcuchów prostszych sieci neuronowych. Ta inwestycja pozwala jej poczynić znaczne postępy w rozpoznawaniu mowy i obrazu. Ich ostatnim nabytkiem w tym obszarze jest startup Deep Learning o nazwie DeepMind, za który zapłacili około 400 milionów dolarów. W ramach warunków umowy Google zgodził się na utworzenie rady ds. Etyki w celu zapewnienia bezpiecznego rozwoju technologii AI.

Jednocześnie IBM opracowuje systemy Watson 2.0 i 3.0, które są w stanie przetwarzać obrazy i wideo oraz argumentować w obronie wniosków. Przedstawili prostą, wczesną demonstrację zdolności Watsona do syntezy argumentów za i przeciw tematowi w demonstracji wideo poniżej. Wyniki są niedoskonałe, ale imponujący krok niezależnie.

Żadna z tych technologii nie jest obecnie sama w sobie niebezpieczna: sztuczna inteligencja jako pole wciąż stara się dopasować umiejętności opanowane przez małe dzieci. Programowanie komputerowe i projektowanie AI to bardzo trudna, wysokopoziomowa umiejętność poznawcza i prawdopodobnie będzie to ostatnie ludzkie zadanie, w którym maszyny będą biegły. Zanim przejdziemy do tego punktu, będziemy mieć także wszechobecne maszyny które potrafią prowadzić Oto jak dostaniemy się do świata pełnego samochodów bez kierowcówProwadzenie pojazdu jest żmudnym, niebezpiecznym i wymagającym zadaniem. Czy pewnego dnia może to zostać zautomatyzowane dzięki samochodowej technologii Google? Czytaj więcej , uprawiać medycynę i prawoi prawdopodobnie także inne rzeczy o głębokich konsekwencjach ekonomicznych.

Czas, jaki zajmie nam dotarcie do punktu zwrotnego samodoskonalenia, zależy tylko od tego, jak szybko mamy dobre pomysły. Prognozowanie tego rodzaju postępów technologicznych jest niezwykle trudne. Wydaje się nieuzasadnione, że możemy być w stanie zbudować silną sztuczną inteligencję za dwadzieścia lat, ale nie wydaje się również nierozsądne, że może to potrwać osiemdziesiąt lat. Tak czy inaczej, w końcu tak się stanie i istnieje powód, by sądzić, że kiedy to się stanie, będzie to wyjątkowo niebezpieczne.

Jeśli więc zaakceptujemy, że będzie to problem, co możemy z tym zrobić? Odpowiedzią jest upewnienie się, że pierwsze inteligentne maszyny są bezpieczne, aby mogły uruchomić się do znacznego poziomu inteligencji, a następnie chronić nas przed niebezpiecznymi maszynami wyprodukowanymi później. To „bezpieczeństwo” jest definiowane poprzez dzielenie się ludzkimi wartościami oraz chęć ochrony i pomocy ludzkości.

Ponieważ nie możemy właściwie usiąść i zaprogramować ludzkich wartości na maszynie, prawdopodobnie konieczne będzie zaprojektowanie funkcji narzędziowej, która wymaga, aby maszyna obserwuj ludzi, dedukuj nasze wartości, a następnie staraj się je maksymalizować. Aby ten proces rozwoju był bezpieczny, przydatne może być również opracowanie sztucznej inteligencji, która jest specjalnie zaprojektowana nie mieć preferencje dotyczące ich funkcji użyteczności, pozwalając nam je korygować lub wyłączać bez oporu, jeśli zaczną błądzić podczas rozwoju.

Wiele problemów, które musimy rozwiązać, aby zbudować bezpieczną inteligencję maszyny, jest matematycznie trudnych, ale istnieją powody, by sądzić, że można je rozwiązać. Nad tym zagadnieniem pracuje wiele różnych organizacji, w tym Future of Humanity Institute w Oksfordziei Instytut badawczy inteligencji maszynowej (które finansuje Peter Thiel).

MIRI jest szczególnie zainteresowany opracowaniem matematyki potrzebnej do zbudowania przyjaznej AI. Jeśli okaże się, że sztuczna inteligencja bootstrapowania jest możliwa, to rozwinięcie tego rodzaju Technologia „przyjaznej AI”, jeśli się powiedzie, może okazać się najważniejszą rzeczą, jaką mają ludzie kiedykolwiek zrobione.

Czy uważasz, że sztuczna inteligencja jest niebezpieczna? Martwisz się, co może przynieść przyszłość AI? Podziel się swoimi przemyśleniami w sekcji komentarzy poniżej!

Kredyty graficzne: Lwp Kommunikáció Via Flickr, „Sieć neuronowa„Przez fdecomite” img_7801„, Steve Rainwater,„ E-Volve ”, Keoni Cabral,„nowy_20x„Robert Cudmore:„Spinacze„, Autor: Clifford Wallace

Andre, pisarz i dziennikarz z południowego zachodu, gwarantuje funkcjonalność do 50 stopni Celsjusza i jest wodoodporny do głębokości dwunastu stóp.