Reklama

Gdy patrzysz na zdjęcie zrobione smartfonem, jedno jest łatwiej odróżnić od zdjęcia zrobionego poważnym aparatem - głębia ostrości. Zdjęcia zrobione aparatem dSLR często mają nieco rozmyte tło, a obiekt zdjęcia jest ostry i wyskakuje. AfterFocus to aplikacja dla Android i iPhone który obiecuje zapewnić taki sam wygląd zdjęć smartfona.

Gdy patrzysz na zdjęcie zrobione smartfonem, jedno jest łatwiej odróżnić od zdjęcia zrobionego poważnym aparatem - głębia ostrości. Zdjęcia zrobione aparatem dSLR często mają nieco rozmyte tło, a obiekt zdjęcia jest ostry i wyskakuje. AfterFocus to aplikacja dla Android i iPhone który obiecuje zapewnić taki sam wygląd zdjęć smartfona.

Krótko wspomniał o tym AfterFocus: przenieś fotografię podobną do DSLR na swój telefon z Androidem Czytaj więcej w katalogu MakeUseOf, ale dziś zamierzam go przetestować i uruchomić w aplikacji prawdziwe zdjęcie zrobione dziś rano w mojej kuchni. Podekscytowany? Powinienem mieć taką nadzieję.

Oryginalne zdjęcie

Po pierwsze, oto z czym musimy współpracować:

Tak, to ja, w koszulce Cookie Monster. Nie jest to świetne zdjęcie, ale jest to typowa jakość smartfona: wszystko jest dość jednolicie skupione i na początku nic nie jest zbyt chwiejne lub rozmyte. Zobaczmy teraz, co możemy z tym zrobić.

Interfejs AfterFocus

Pierwszą rzeczą, którą powinieneś wiedzieć o pracy z AfterFocus jest to, że nie jest on w pełni automatyczny. Musisz powiedzieć mu, co chcesz rozmazać i co należy utrzymać.

Po uruchomieniu AfterFocus aplikacja pozwala zrobić zdjęcie za pomocą wbudowanej aplikacji aparatu lub wybrać istniejące zdjęcie z albumu do pracy. The „Zrób dwa zdjęcia”Opcja nie jest jeszcze aktywna na Androidzie. Jest zarezerwowany dla wersji Pro aplikacji, która pojawi się w Google Play w maju. Jest to funkcja, która ma ułatwić rozpoznawanie pierwszego planu z tła po ustawieniu ostrości przez zrobienie zdjęcia, lekkie przesunięcie aparatu i zrobienie kolejnego zdjęcia.

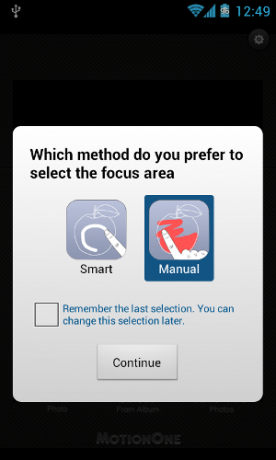

Mamy już zdjęcie, z którym chcemy pracować, więc właśnie wybrałem je z galerii. Następnie AfterFocus zapytał mnie, jak chcę wybrać obszar ostrości:

Ręczny wybór ostrości

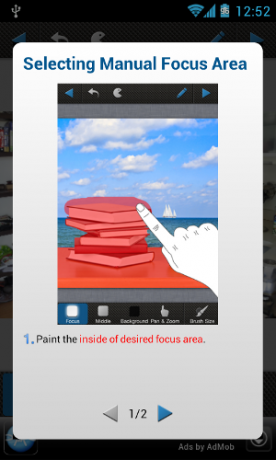

W tym poście pokażę obie metody, ale najpierw zdecydowałem się na Manual. Po wybraniu tej metody AfterFocus wyświetla szybki dwustopniowy samouczek:

To naprawdę bardzo proste. Zasadniczo malujesz zdjęcie, aby wskazać, które obszary chcesz zachować ostrość i jakie obszary chcesz rozmazać:

Szybkie spojrzenie na moją pracę ręczną (a raczej „pracę palcami”) pokazuje problem z tą metodą: bardzo łatwo jest narysować grube linie i zepsuć wszystko. Możesz spróbować naprawić szkody, cofając je lub powiększając i rysując pędzlem BG (tło):

Mimo to bardzo ręczny proces podatny na błędy. Szybko poświęciłem powiększanie i przesuwanie, poprawianie konturu, aż skończyłem z tym:

Lepiej, ale wciąż bałagan. Mówiąc realistycznie, jest to tak długo, jak długo ktoś poświęca na ulepszenie konturu. Czas przejść do następnego kroku, naciskając „Kolejny”Trójkąt w prawym górnym rogu.

![Afterfocus [22]](/f/95ab60600cc5ef081f90a073a75a5cbb.png)

AfterFocus natychmiast stosuje efekt rozmycia tła i nawet na ekranie smartfona widzę, że pozostawia wiele do życzenia. Nadal jednak, zastosujmy niektóre efekty i zobaczmy, co otrzymamy. Dolny pasek narzędzi pozwala kontrolować stopień rozmycia zastosowanego w tle:

![Afterfocus [24]](/f/72fd4f08827f789dc9fda88146abb4c3.png)

Możesz także wybrać kształt apertury:

![Afterfocus [28]](/f/8191c14ca9f2600182758ff8b637427a.png)

I oczywiście zastosuj kilka filtrów:

![Afterfocus [30]](/f/f0387c219fa6a73864d35ac4c7b1010a.png)

Naprawdę nie jestem pewien co do filtrów w stylu vintage: myślę, że za 15 lat nie będę szczęśliwy, gdy odkryję, że wszystkie moje zdjęcia z tej epoki są wypełnione efektami retro, które degradują obraz. Niezależnie od tego, czy lubisz filtry w stylu vintage, AfterFocus je ma.

OK, skończone. Oto, co mamy:

![Afterfocus [32]](/f/7f5b5bfe969b499de40637105069e43a.png)

Tło jest zdecydowanie rozmazane, a AfterFocus nie przesadził z wybranym przeze mnie efektem przetwarzania krzyżowego, co jest miłe. Mimo to na pewno widać dziwne poruszenia wokół mojego prawego ramienia (po lewej na zdjęciu), gdzie pomieszałem ręczny wybór, a nie wspomnieć, że przód zdjęcia jest nieostry, co jest po prostu dziwne (ale to moja wina, ponieważ początkowo go nie wyróżniłem).

Smart Focus

Wróciłem do początku procesu z tym samym zdjęciem, aby zobaczyć, jak działa Smart Focus. Oto sześciostopniowy samouczek wraz z ładnym wideo (sformatowanym do trybu portretowego, co jest świetne):

![Afterfocus [34]](/f/91fa54be2d725dd631c541bd9cc317d8.png)

Chodzi o to, że nie malujesz obiektów, ale po prostu „podpowiedź”: białe linie oznaczają pierwszy plan, czarne linie oznaczają tło. AfterFocus próbuje samodzielnie ustalić granice obiektów.

Czas więc narysować na sobie kilka białych linii:

![Afterfocus [36]](/f/4d19bfe6011bb197d57c09c0b55666b7.png)

Początkowo wynik nie był bardzo dobry:

![Afterfocus [38]](/f/3b2c2a55fb0fcbb64f8ac570fd583342.png)

AfterFocus zdecydował, że całe zdjęcie jest „na pierwszym planie”. OK, dodajmy kilka czarnych linii:

![Afterfocus [40]](/f/6b29b2234af910f941c251b2105502ef.png)

O wiele, wiele lepiej, tylko AfterFocus uważa, że moja wielka biała głowa jest częścią ściany. Nie najlepiej. Szybka poprawka później wygląda następująco:

![Afterfocus [42]](/f/ab8c98c4b9a919e0bf7a710c31b08d06.png)

Ogólnie rzecz biorąc, wybór jest dość płynny, a wykrywanie granic obiektów działa dobrze. Ta metoda zajęła znacznie mniej czasu niż metoda ręczna i przyniosła lepsze wyniki. Następnie zastosuję taki sam dokładny efekt do obrazu, jak poprzednio, i spójrzmy na wynik:

![Afterfocus [44]](/f/7c92b66f7613afac79c1f7bce76dd44f.png)

Lepiej, ale zdecydowanie nie idealnie. Ta metoda sprawiła, że moje ramiona były w prawo, ale całkowicie zawaliłem lewą stronę głowy (moje ucho wygląda dziwniej niż kiedykolwiek), a także część koszuli w lewym dolnym rogu zdjęcia. Mogło to naprawić trochę więcej pracy na etapie podpowiedzi, ale znowu celowo nie spędziłem dużo czasu na tej scenie, ponieważ nie sądzę, by większość użytkowników to zrobiła. W końcu to nie jest Photoshop.

Poza tym pierwszy plan wygląda na bardzo sztuczny i całkowicie zaburza efekt: na lustrzance ostrość nie spada tak gwałtownie.

Porównanie obrazów

Oryginał:

![Afterfocus [46]](/f/8755ff3366d27f1a9f592b602ccc1852.png)

Ręczny wybór pierwszego planu:

![Afterfocus [48]](/f/4c9bf99e977318a678c8ef7d40959843.png)

Inteligentny wybór pierwszego planu:

![Afterfocus [50]](/f/c619d34e72c45515c202d4d926530859.png)

Po rozczarowujących wynikach mojego początkowego spinu z wyborem inteligentnego pierwszego planu wróciłem i edytowałem ostrożniej, uzyskując bardziej akceptowalny wynik:

Skupienie wokół mojego ucha wciąż wygląda naprawdę dziwnie, ale pierwszy plan wokół mojego garnka mokki jest teraz bardziej wiarygodny - zdjęcie nie rozprasza od razu w „hej, to nie jest prawdziwy” sposób.

Końcowe przemyślenia

AfterFocus to niezły chwyt, ale moje zdjęcia nadal wyglądają, jakby pochodziły ze smartfona. Dedykowani użytkownicy, którzy mają czas do stracenia, prawdopodobnie uzyskają lepsze wyniki niż ja, chociaż uważam, że ostatnia próba inteligentnego wyboru nieco poprawiła zdjęcie. Fajnie, że zabytkowe filtry nie są tak przesadne i nie niszczą całkowicie zdjęcia.

Poinformuj nas, co myślisz o aplikacji i jakie wyniki udało Ci się uzyskać dzięki zdjęciom.